明敏 发自 凹非寺米菲兔 足交

量子位 | 公众号 QbitAI

千亿参数内最强推理大模子,刚刚易主了。

32B——DeepSeek-R1的1/20参数目;免费商用;且全面开源——模子权重、锤真金不怕火数据集和无缺锤真金不怕火代码,都开源了。

这等于刚刚亮相的Skywork-OR1 (Open Reasoner 1)系列模子——

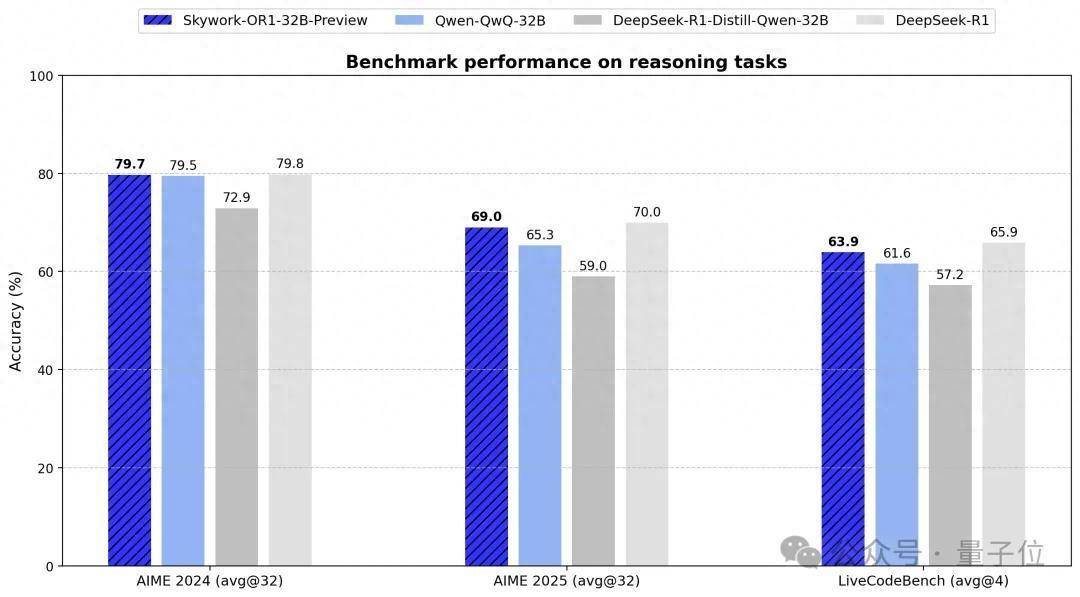

通用32B尺寸(Skywork-OR1-32B)统统特出同范围阿里QwQ-32B;代码生成失色DeepSeek-R1,但性价比更高。

△Skywork-OR1-32B-Preview

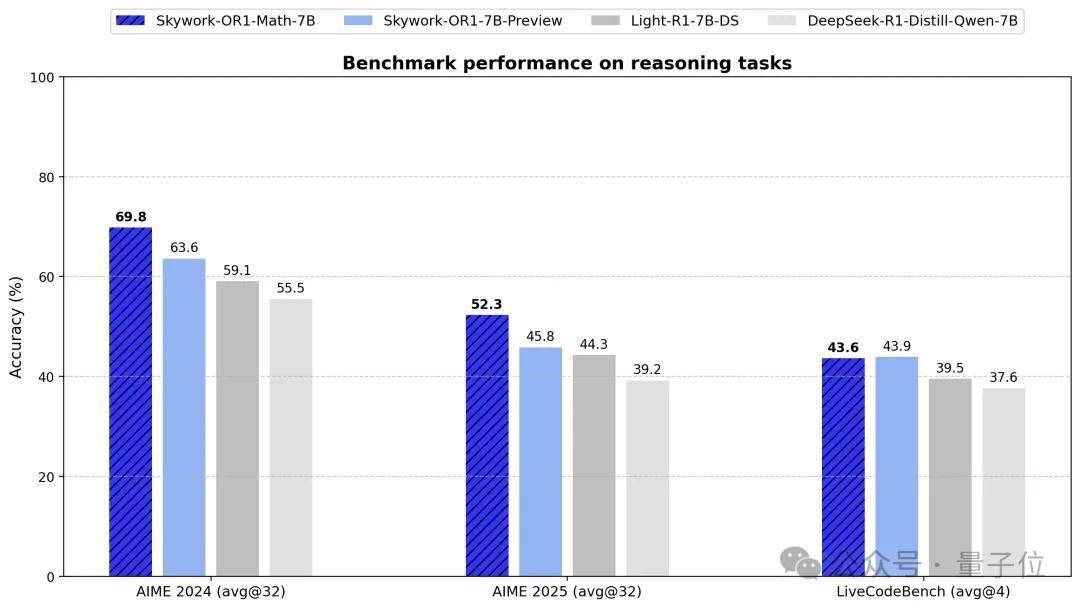

数学推理方面:7B、32B都达到同范围最优,数学专项模子(Skywork-OR1-Math-7B)推崇更杰出。

Skywork,天工是也,来自AIGC巨头玩家昆仑万维。

Skywork-OR1系列模子现已全面开源,模子权重、锤真金不怕火数据集和无缺锤真金不怕火代码,整个资源均已上传至GitHub和Huggingface平台。配套的本领博客已发布于Notion平台,留神文牍了数据处理进程、锤真金不怕火模范和关节本领发现,为社区提供了统统可复现的履行参考。

Skywork-OR1系列开源地址:https://github.com/SkyworkAI/Skywork-OR1 (包含模子,代码,数据)昆仑万维天工团队更多开源技俩:https://huggingface.co/Skywork当今Skywork-OR1-7B和Skywork-OR1-32B的才调还在接续擢升,在两周内会发布两个模子的郑再版块,同期也会推出更为系统详备的本领回报,共享推理模子锤真金不怕火中的训导与瞻念察。

3款模子全量开源Skywork-OR1 (Open Reasoner 1) 系列开源共有3款模子:

Skywork-OR1-Math-7B:专注数学范围的专项模子,同期也具有较强的代码才调。Skywork-OR1-7B-Preview:会通数学与代码才调,兼顾通用与专科性Skywork-OR1-32B-Preview:面向高复杂度任务、具备更强推理才调的旗舰版块团队对比了Skywork-OR1系列在AIME24、AIME25、LiveCodeBench上的推崇。

开心情色网AIME24/25是好意思国数学邀请赛基准测试,LiveCodeBench主要评估大讲话模子代码生成和编程才调。

在评测方面,Skywork-OR1系列模子引入avg@k行动中枢评估方针,用于估量模子在进行k次尝试时告成处置问题的平均推崇。

传统的pass@k方针仅温雅“至少一次告成”,相对而言avg@k更温雅模子的贯通性和举座推理才调,为模子实践落地提供更全面确实的参考。

在数学方面,通用模子Skywork-OR1-7B-Preview和Skywork-OR1-32B-Preview在AIME24与AIME25数据集上均结束了同参数范围下最优推崇,32B举座推崇基本与DeepSeek-R1皆平。

编程方面,通用模子Skywork-OR1-7B-Preview与Skywork-OR1-32B-Preview在LiveCodeBench上均获得了同等参数范围下的最优性能。

举座而言,Skywork-OR1-32B-Preview致使与DeepSeek-R1的差距相等轻飘。要知说念后者的参数范围是前者的20倍,这意味着Skywork-OR1能带来更具性价比的性能推崇。

由此详细来看,Skywork-OR1-32B-Preview成为面前同范围最强中语推理模子,亦然现役相沿免费商用的模子中最强且最具性价比的成员之一。

此外,数学专项模子Skywork-OR1-Math-7B在AIME24/25的推崇远超面前主流7B级模子,致使接近蒸馏版Deepseek-32B模子同等水平(DeepSeek-R1-Distill-Qwen-32B)。

如下为该模子在AIME24上的锤真金不怕火准确率弧线。

最终模子在AIME24和AIME25上分袂达到69.8%和52.3%,特出了OpenAI-o3-mini (low),达到了面前尺寸SOTA性能。与此同期,该专项模子在代码范围也推崇出了较好的泛化性(锤真金不怕火后,Livecodebench从37.6%擢升到43.6%)。

△OpenAI-o3-mini(low)的AIME24分数来自官网,AIME25分数来自评测网站https://matharena.ai/

前年11月,昆仑万维发布国内首款中语复杂推理模子Skywork-o1,Skywork-OR1系列模子恰是在此基础上迭代而来。

不同于浅易复刻OpenAI o1模子,Skywork-o1内生出了念念考、计算、反念念等才调。它共包括三款模子Skywork-o1-Open、SI’m kywork-o1-Lite和Skywork-o1-Preview,分袂适用于不同的欺诈场景,不错称心开源到高性能推理的万般化需求。

Skywork-OR1系列站在Skywork-o1的肩膀上有了更强基座,但想要如斯高大,也离不开一系列先进本领加持。

背后诀窍:AGI本领洞藏,锤真金不怕火后果擢升50%Skywork-OR1在数据处理、锤真金不怕火计谋等方面都作念了进一步翻新。

领先在数据方面。

为擢升模子在数学和代码方面才调,Skywork-OR1构建了一个高质料数学和代码数据集。

团队策画了三个圭臬进行数据筛选:可考据性(Verifiable)、正确性(Correct)与挑战性(Challenging),剔除无法自动考据的说明注解类题目、有误题目、和费劲unit test的代码问题。

数学范围臆测网罗11万说念题目,主要依赖NuminaMath-1.5(含约89.6万题),采选如AIME和Olympiads等较难子集,并补充了如DeepScaleR、Omni-MATH、AIME 1983-2023难题开头。

代码范围网罗了13.7k条高质料代码问题,主要以LeetCode和TACO数据为主,保留了单位测试无缺、考据通过的问题,并进行向量级语义去重。

在数据过滤部分,团队对每说念题进行了多轮采样并考据谜底,以幸免“全对”或“全错”征象对计谋学习无效——模子生成一皆错误,无法提供灵验的学习信号;“全对”意味着模子已统统掌持,赓续学习会花费臆测资源。

并通过东说念主类审核聚首LLM自动判题机制,对语义不清、信息不全、模式错误或含有无关内容的技俩进行计帐。使用LLM-as-a-Judge剔裁撤约1-2K说念质料不达标的数学题。

其次在强化学习部分,Skywork-OR1使用GRPO(Group Relative Policy Optimization)进行锤真金不怕火,并引入一系列优化计谋。

在锤真金不怕火时数据优化上,一方面接收双重过滤计谋:

离线过滤:锤真金不怕火前使用待锤真金不怕火模子评估数据,剔除正确率为0或1的样本;在线过滤:每个epoch动态移除上一轮已统统掌持的数据,确保模子接续靠近有挑战性的内容。另一方面使用拒却采样(Rejection Sampling)进行更良好的及时筛选,在每个锤真金不怕火技艺中动态剔除面前锤真金不怕火步中采样正确率为0或1的样本。这么不错看护policy loss、entropy loss和KL loss的合理比例,驻扎非policy loss比重相当加多导致的锤真金不怕火不贯通。

在锤真金不怕火Pipeline优化上主要作念了两方面的探索。

(1)多阶段锤真金不怕火(Multi Stage Training):从小窗口开动,渐渐加多高下文长度(seq_len),不错促使模子在有限token内高效完成任务;随后渐渐推广窗口大小,迭代加多生成长度,使模子渐渐掌持更复杂的长链念念维才调。实考据明,多阶段锤真金不怕火能显耀镌汰锤真金不怕火时刻,同期统统保持模子的长度推广才调。

(2)截断上风掩码(Truncated Advantage Mask):在多阶段锤真金不怕火初期,由于高下文窗口结果,复杂问题的回应可能被截断。因此团队究诘了两种处理窗口结果下截断样本的计谋Adv-Mask Before(臆测上风前排斥截断样本)和Adv-Mask After(臆测后将截断样本上风置零)。说明注解即使不屏蔽截断样本,模子也能灵验恰当并赶快擢升性能,也说明注解多阶段锤真金不怕火框架的鲁棒性。

此外,在强化学习锤真金不怕火中还要保险模子的探索才调。

团队进行了三方面探索。

第一,高温度采样。接收τ=1.0(高于常见的0.6)看护更高群组内万般性,既保证满盈正确样本提供学习信号,又允许模子探索更凡俗处置旅途。

第二,擢升内在锤真金不怕火万般性。通过良好数据过滤、加多批量大小和减少数据重叠使用,不错从源流上驻扎模子过早优化到单一输出地方,同期也保持较高熵值,幸免局部最优。

第三,自恰当熵限度。只消在熵值低于阈值时才提供熵加多饱读吹,设定认识熵值并动态调遣亏蚀整个,同期最小化对平淡锤真金不怕火轨迹的打扰。

终末在保险强化学习锤真金不怕火的贯通性,团队对亏蚀函数进行优化。

第一,移除KL亏蚀。究诘中发现即使基于高质料SFT模子锤真金不怕火,KL亏蚀仍结果性能擢升。因此,除特定阶段外,团队在整个公征战布的Skywork-OR1系列模子中均未使用KL亏蚀项,这使模子有时更充分地探索和优化推理才调。

第二,token级计谋亏蚀。移除了计谋亏蚀中的长度归一化项,并将亏蚀在锤真金不怕火批次内的整个token上进行平均,以擢升优化过程的一致性与贯通性。

(更多本领细节和实验对比不错参照本领博客https://capricious-hydrogen-41c.notion.site/Skywork-Open-Reaonser-Series-1d0bc9ae823a80459b46c149e4f51680,或赓续温雅后续发布的本领回报。)

在此锤真金不怕火计谋下,Skywork-OR1-7B和Skywork-OR1-32B-Preview通用推理模子仍处于接续擢升景况,本次开源是面前锤真金不怕火过程中性能最好的checkpoint。

瞻望两周后,具备更全面才调擢升及更高大推理才调的Skywork-OR1郑再版块将与全球碰头,一样全面开源。

Hugging Face单月下载量超7万自2023年以来,在全面拥抱AIGC后,昆仑万维一直相持开源,股东本领平权。代表性动作包括:

2023年:开源百亿级大讲话模子Skywork-13B系列及600GB高质料数据集。2024年:陆续开源数字智能体研发器用包AgentStudio、4000亿参数MoE超等模子、Skywork-MoE、 Skywork-RM/PRM,Skywork-o1。本年以来,开源的频率变得更高。第一季度开源动作包括:

面向AI短剧生成的视频生成模子SkyReels-V1:下载量周榜前十R1V视觉念念维链推理模子:单月下载8.75kSkywork-OR1新系列:长念念维链推理模子。不难发现,昆仑万维开源全面且透彻,同期兼顾产业需求。

一方面,它的基础模子布局相等全面,袒护AIGC全范围,文生文、文生视频、文生音乐等。

另一方面,这些模子从底层策画上即接洽了实践落地的需求。提供更高性价比、更直快算力,如SkyReels-V1则是看到了垂直范围的落地前程,模子下载量赶快增长也考据了这一市集需求。

最关节的是,这些模子的开源程度也相当透彻,十分利于征战者使用。

在Hugging Face上,昆仑万维开源模子的下载量相当可不雅,累计上月下载量进步7万。

△部分展示

如今,底层模子竞争日趋尖锐化,全球AI范围正以惊东说念主的速率迭代演进,险些每个月都有值得温雅的模子发布,这种翻新密度前所未有。

行动国内最早All in AIGC赛说念的先驱之一,昆仑万维自2023年起便构建了全地方的前沿布局:从基础大模子到垂直欺诈,从本领研发到生态缔造。尤其值得安靖的是,昆仑万看护续为征战者社区提供高质料的模子和器用链,这种相持普惠的本领理念也为其提供了私有竞争力。

面前,开源生态正展现出前所未有的活力。

这些开源翻新正快速浸透到互联网、制造业、医疗、指示等范围,股东着AI本领信得过结束范围化落地。在这一进度中,以昆仑万维为代表的开源践行者的每一步探索,都将真切影响AI产业的发展轨迹。

别传Skywork-OR1郑再版,也如故快马加鞭,行将对外发布。

Skywork开源系列(2025)传送门:

1、中语推理模子Skywork-OR1:

https://github.com/SkyworkAI/Skywork-o1

2、视觉念念维链推理模子Skywork-R1V:

https://github.com/SkyworkAI/Skywork-R1V

3、AI短剧生成模子SkyReels-V1:

https://github.com/SkyworkAI/SkyReels-V1

— 完 —

量子位 QbitAI · 头条号签约

温雅咱们米菲兔 足交,第一时刻获知前沿科技动态